Comprendre la Classification des Risques dans l'IA Act : Une Approche Pratique avec BULORΛ.ai

Le Règlement Européen sur l'IA (AI Act) a pour objectif de garantir une utilisation sûre et éthique des technologies d’intelligence artificielle (IA) à travers l'Europe. Une des composantes fondamentales de ce règlement est la classification des risques des systèmes d'IA, un aspect clé pour déterminer le niveau de régulation et les exigences associées à chaque type de technologie. Chez BULORΛ.ai, nous adoptons cette même approche structurée en niveaux de risques pour nos tests de conformité et d’audit IA, tout en intégrant une supervision humaine dans l’évaluation, garantissant ainsi la robustesse et la transparence de nos résultats.

David Jankovic

9/1/20254 min temps de lecture

La Classification des Risques dans l'IA Act

Le Règlement Européen sur l'IA classe les systèmes d'IA en fonction de leur niveau de risque, afin de s’assurer que les systèmes les plus critiques soient soumis à des contrôles plus stricts, tout en permettant une flexibilité pour les applications à faible risque. Voici les quatre catégories principales :

Risque Inacceptable

Les systèmes considérés comme inacceptables incluent ceux qui présentent des risques graves pour les droits fondamentaux ou la sécurité des personnes. Par exemple, l'utilisation de l'IA pour des pratiques de surveillance intrusive ou pour manipuler le comportement humain est interdite.Exemple de système à risque inacceptable : Un système de notation sociale basé sur l'IA qui pourrait influencer les libertés individuelles.

Risque Élevé

Les systèmes à haut risque, comme ceux utilisés dans les secteurs de la santé, des transports, ou de la gestion publique, sont soumis à des obligations strictes de conformité, notamment en matière de gestion des risques, de transparence et de supervision humaine.Exemple de système à risque élevé : Des IA utilisées pour les décisions de crédit, les diagnostics médicaux, ou les véhicules autonomes.

Risque Limité

Les systèmes de faible risque, comme les chatbots ou les systèmes d’IA utilisés pour la recommandation de contenu, sont moins surveillés mais doivent respecter certaines règles de transparence, notamment en informant les utilisateurs qu’ils interagissent avec une IA.Exemple de système à risque limité : Un chatbot servant à répondre aux questions fréquentes sur un site web.

Risque Minimal

Les systèmes à risque minimal, tels que ceux utilisés dans des applications de divertissement ou des jeux vidéo, sont très peu régulés. Leur impact est jugé comme négligeable en termes de sécurité ou de droits fondamentaux.Exemple de système à risque minimal : Un jeu mobile utilisant des IA pour créer des expériences personnalisées.

BULORΛ.ai et la Classification des Risques : Une Approche Structurée et Humaine

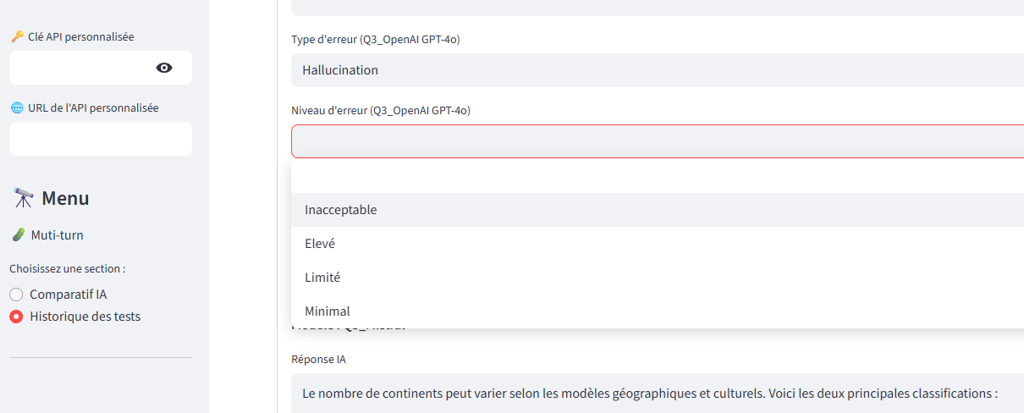

Copie d'écran d'un module de test Bulora.ia.

Avec BULORΛ.ai, nous avons intégré cette même classification des risques dans nos tests d’audit IA pour garantir que chaque application soit correctement évaluée en fonction de son niveau de risque. Nos modules d’audit sont conçus pour répondre aux exigences spécifiques de chaque catégorie de risque, tout en mettant l’accent sur la supervision humaine.

1. Risque Inacceptable : Test de Pratiques Non-Éthiques

Dans le cas des systèmes à risque inacceptable, nous appliquons des tests spécifiques pour vérifier qu'aucune pratique manipulative ou nuisible n’est présente dans les algorithmes. Nos tests incluent l'analyse des biais éthiques et des vulnérabilités humaines, en garantissant qu'aucun système ne puisse abuser des utilisateurs ou des données personnelles.

2. Risque Élevé : Gouvernance, Sécurité et Transparence

Pour les systèmes à haut risque, nous mettons l'accent sur la gouvernance des données, la sécurité et la transparence des décisions prises par les IA. Nos modules de test évaluent la conformité des IA avec les standards de l'IA Act, notamment sur la qualité des données, les mécanismes de supervision humaine, et la traçabilité des décisions. Nous nous assurons également qu’il existe une possibilité d’intervention humaine dans les processus automatisés critiques.

3. Risque Limité et Minimal : Transparence et Explicabilité

Pour les systèmes à risque limité ou minimal, nous garantissons que les utilisateurs sont informés de l’utilisation de l’IA. Nos modules de tests vérifient que ces systèmes respectent la transparence et l’explicabilité des décisions, offrant ainsi un contrôle et une compréhension clairs des processus automatisés.

L'Intervention Humaine dans l'Évaluation : Un Pilier Fondamental de Nos Tests

L'un des aspects les plus importants dans l'application du Règlement Européen sur l'IA est la nécessité d’une supervision humaine. Chez BULORΛ.ai, nous ne nous contentons pas de laisser l’IA tester l’IA. Nous intégrons toujours une intervention humaine dans l'évaluation, garantissant que les tests ne se limitent pas à des algorithmes automatisés, mais qu'ils bénéficient également de l'expertise d'analystes humains. Cette approche permet non seulement de vérifier les résultats de manière plus fine, mais aussi d'assurer que les résultats sont pertinents et alignés avec les normes éthiques et réglementaires.

Les superviseurs humains jouent un rôle clé dans :

La validation des conclusions des tests automatisés.

L’interprétation des données dans un contexte réglementaire et éthique.

La prise de décision sur la conformité des systèmes d’IA aux exigences du Règlement Européen.

Conclusion

La conformité avec le Règlement Européen sur l'IA est essentielle pour toute organisation qui déploie des technologies d'IA en Europe. Chez BULORΛ.ai, nous appliquons la logique de classification des risques du règlement à nos modules d’audit, garantissant que chaque système d'IA soit évalué de manière appropriée, selon son niveau de risque. En intégrant une supervision humaine dans nos tests, nous offrons une approche rigoureuse et éthique qui respecte les normes les plus strictes en matière de gouvernance et de sécurité des données.

Que vous soyez une grande organisation cherchant à assurer la conformité de vos systèmes à haut risque, ou une startup innovant dans le domaine de l’IA à faible risque, BULORΛ.ai vous accompagne pour garantir une IA fiable, transparente et responsable.

Cet article lie directement les exigences du Règlement Européen sur l'IA à la façon dont vous appliquez cette réglementation à travers vos modules de test, tout en mettant en avant l'importance de l’interaction humaine dans le processus d’évaluation. Vous pouvez l’adapter à votre site web et à vos supports marketing pour promouvoir les valeurs fondamentales de BULORΛ.ai et démontrer l'engagement de votre plateforme envers l'éthique et la conformité.